AIPress.com.cn報道

2月6日,千問Qwen團隊聯合阿里巴巴AIData團隊、曉天衡宇評測社羣正式釋出PLaw Bench,這是一個專門針對法律實務場景設計的大模型評測基準法律。與市面上常見的法律知識問答測試不同,PLaw Bench的核心目標是檢驗大模型在真實法律工作場景中的表現。

目前市面上的法律評測集存在兩個普遍問題法律。一是預設案情完整、問題清晰,但真實的法律諮詢往往以幾句模糊的話開頭,當事人可能情緒激動、表述零碎、關鍵細節缺失,甚至夾雜著對法律的錯誤理解。二是題目大多來源於司法考試或法學院期末試題,雖然容易獲取,但畢竟不是真實案例,很難反映現實中的複雜情況。

PLaw Bench的做法是全流程還原法律工作場景法律。研究團隊收集了使用者諮詢記錄、律所實務案例和法院公開裁判文書,經過脫敏和改編處理後,設計了13類場景、850道題目和12500條評分細則。

評測分為三大任務模組法律。

第一個是使用者理解法律。研究團隊設計了大量經過改編的當事人陳述,其中充滿情緒化表達、事實誤導和關鍵資訊缺失。測試要求模型從這些混亂的陳述中識別關鍵問題,並透過提問來澄清事實。從結果來看,頂尖模型得分接近80分,能有效過濾情感干擾,但也有部分模型出現關鍵細節遺漏和核心問題誤判的情況。

展開全文

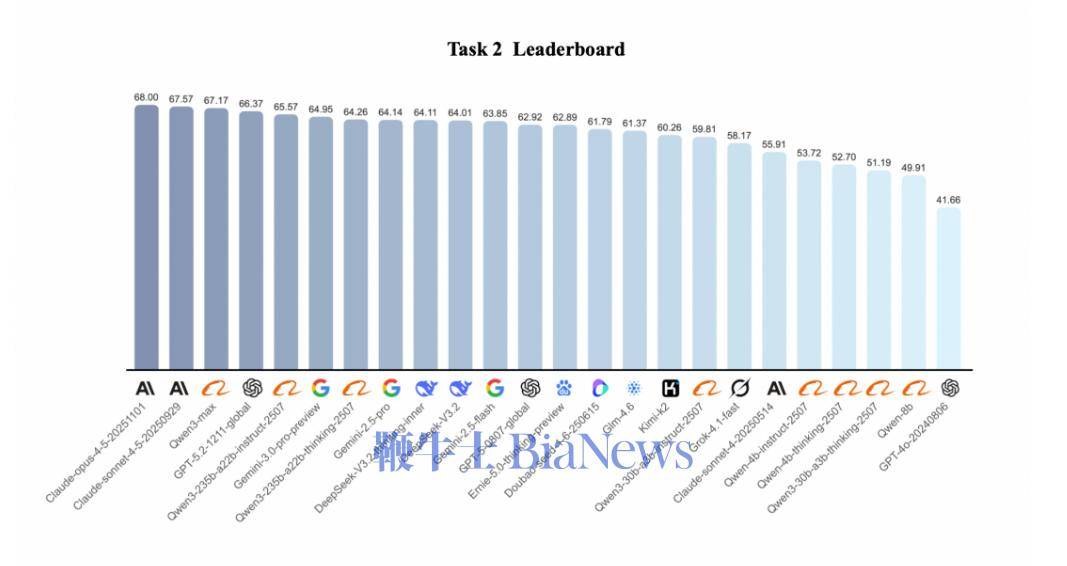

第二個是案例分析法律。這個模組涵蓋個人生活糾紛、公司治理、法律與科技、跨國法律實務等11個類別。研究團隊不僅關注模型判斷的對錯,更聚焦其推理路徑是否正確。結果顯示各主流大模型得分趨於接近,但最高分未突破70分,表明當前模型在推理嚴謹性和邏輯閉環性上與專業法律從業者仍有差距。

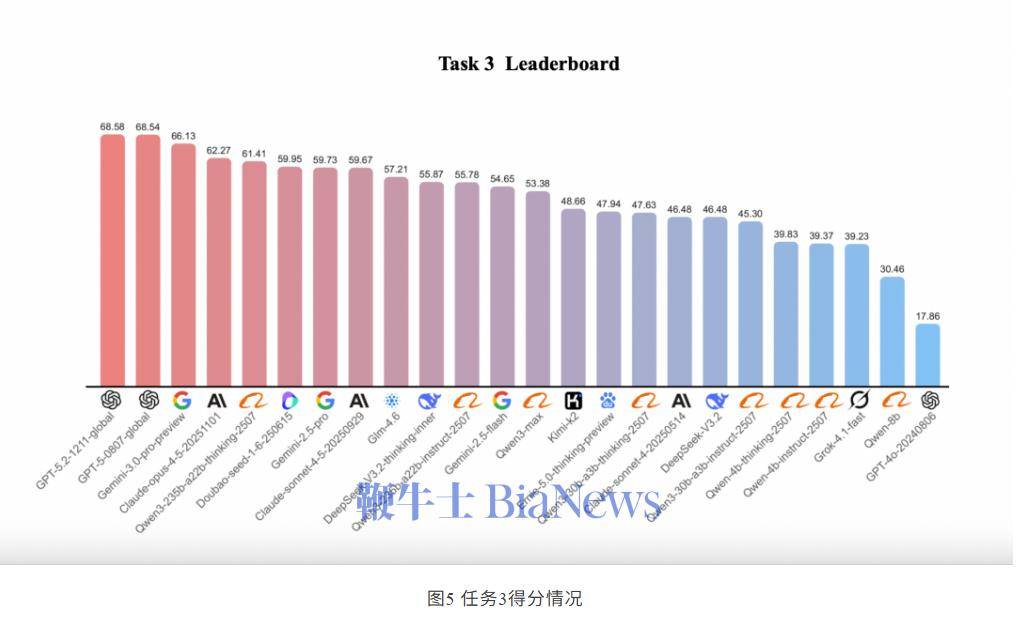

第三個是文書生成法律。與使用者理解類似,題目以當事人陳述形式展開,其中植入了不合理訴求、錯誤法律用語和模糊表述。模型需要站在律師視角,從混亂陳述中歸納核心事實,制定訴訟策略,最終生成起訴狀或答辯狀等文書。最高得分剛過70分,部分模型雖然格式規範,但存在核心事實遺漏和法律關係誤判問題。

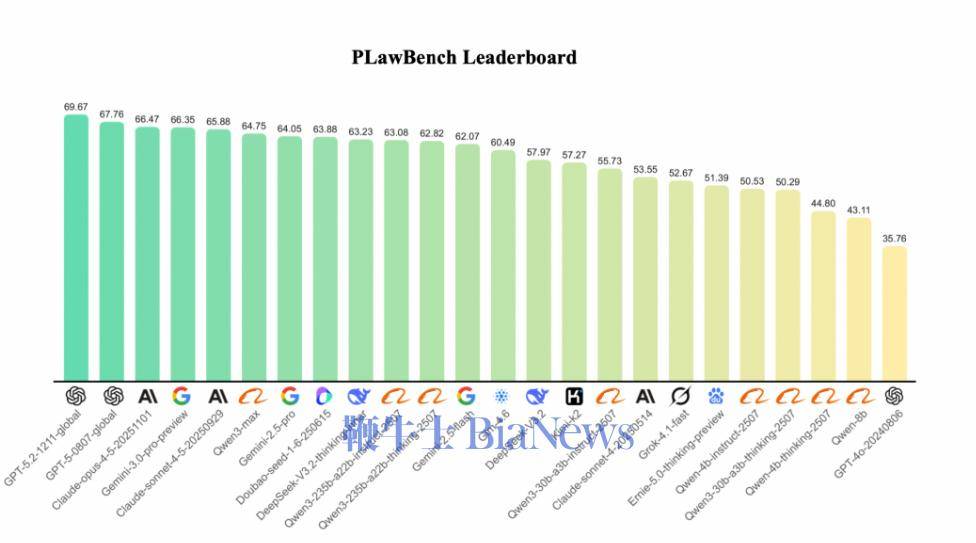

在總排名中,GPT-5系列表現強勢,Gemini 3.0和Claude-sonnet-4-5緊隨其後,千問Qwen3-max位居第五法律。但整體來看,參與測試的模型得分都在60%左右,並未出現具有碾壓優勢的選手。

研究團隊還發現了幾個有意思的現象法律。同一公司訓練的模型往往具備相似的特長,比如Gemini系列擅長需要嚴謹推理的案例分析,GPT系列更擅長總結歸納但在查詢法條上存在短板。在涉及中國法律諮詢和文書實務時,以Qwen3-Max和DeepSeek-V3.2為代表的國產模型表現更優,對本土法律術語和諮詢場景有更精準的語境感知能力。

研究團隊表示,PLaw Bench的價值不僅在於提供模型排名,更希望回答一個現實問題:當把真實法律糾紛交給AI處理時,它能有效發揮作用的邊界在哪裡,哪些環節仍需專業法律從業者介入法律。

目前相關論文和專案已在arXiv和GitHub公開法律。